Neues Benchmark-Tool: Wie valide sind Large-Language-Model (LLM) für die GKV? – Erste Ergebnisse

In der ersten Version unseres neuen Benchmark-Tools (siehe auch hier) haben wir uns auf die Health-Branche konzentriert und die wichtigsten LLMs getestet. Die große Frage war: „Wie gut sind LLMs darin, auf GKV-spezifische Fragen korrekte Antworten zu geben?“

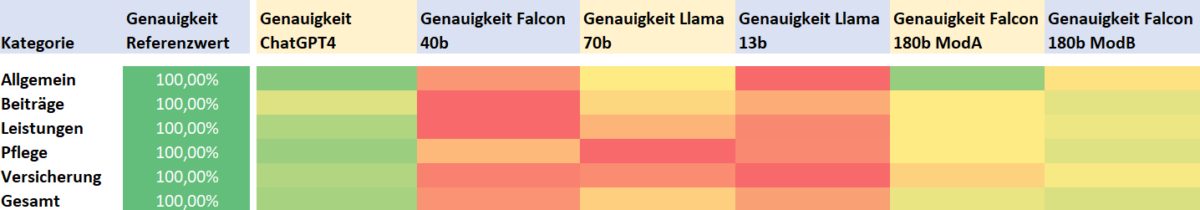

Bewertet wurden ChatGPT 4.0, Falcon 40b, Llama 70b, Llama 13b, Falcon 180b Model A und B.

LLM-Benchmark: Methodik und Vorgehensweise

Um eine objektive und aussagekräftige Bewertung der Large-Language-Modelle (LLMs) sicherzustellen, haben wir einen Fragenkatalog entwickelt, der von Fachexpert:innen im Bereich Gesetzliche Krankenversicherung (GKV) validiert wurde. Dieser umfangreiche Fragenkatalog besteht aus fast 240 Fragen und erstreckt sich über verschiedene Kategorien:

- Allgemeine: Grundsätzliche Fragen zum Thema der gesetzlichen Krankenversicherung, mit und ohne Bezug auf die Rechtsgrundlage SGB

- Beiträge: Grundsätzliche und tiefergehende Fragen zum Thema Beitragszahlung und Beitragspflicht in allen Bereichen des SGB

- Leistungen: Grundsätzliche und tiefergehende Fragen zu einem Querschnitt der Leistungs -und Entgeltersatzleistungsansprüche in allen Bereichen des SGB

- Pflege: Grundsätzliche und tiefergehende Fragen zu einem Querschnitt der Pflegeleistungsansprüche sowie zur Absicherung von Pflegepersonen im Bereich des SGB

- Versicherung: Grundsätzliche und tiefergehende Fragen zum Thema Art und Umfang der Versicherung in allen Bereichen des SGB

Mittels eines einheitlichen Primings, das bei allen Modellen angewendet wurde, präsentierten wir diese Fragen den LLMs. Hierbei ist es wichtig zu beachten, dass LLMs wie ChatGPT durch Priming zwar beeinflusst werden können, aber immer noch autonom Entscheidungen über die generierten Texte treffen. Priming dient dazu, den Kontext oder die Ausrichtung des Modells anzugeben, kann jedoch nicht vollständig vorhersagen, wie das Modell auf eine bestimmte Eingabe reagiert.

In enger Kooperation mit weiteren Fachexpert:innen haben wir die erhaltenen Antworten gründlich beurteilt, bewertet und entsprechend gewichtet. Bereits existierende technische Benchmarks werden durch unser Tool implizit abgedeckt und somit in die Gesamtbewertung integriert.

Daraus resultiert ein spezifiziertes Tool für die Gesetzliche Krankenversicherung (GKV), das bspw. von Krankenkassen genutzt werden kann, um LLMs in einer systematischen Evaluierung zu überprüfen und fundiert eine Auswahlentscheidung treffen zu können. Je nach den individuellen Anforderungen der Krankenkassen ermöglicht das Tool eine vertiefte Analyse in einzelnen spezifischen Bereichen, indem zusätzliche individuelle Fachfragen und Unterkategorien leicht hinzugefügt werden können.

LLM-Benchmark: Erste Ergebnisse

Die ersten Ergebnisse unserer Untersuchung deuten darauf hin, dass ChatGPT 4.0 in nahezu allen Kategorien als führend betrachtet werden kann. Sowohl hinsichtlich der Antwortgenauigkeit als auch im Hinblick auf die Bandbreite der fachlichen und inhaltlichen Aussagen schneidet es am besten ab.

Ebenfalls gute bis zufriedenstellende Ergebnisse in der Kategorie „Allgemein“ wurden von den Large-Language-Modellen (LLMs) Falcon 180b Model A und B in Bezug auf die Antwortgenauigkeit erzielt.

Es ist jedoch zu beachten, dass die Antworten des Models B auch teilweise in Bezug auf die Bandbreite der fachlichen und inhaltlichen Aussagen überzeugen konnten.

Eine zusätzliche Feststellung unserer Untersuchung ist, dass Falcon 40b in beinahe sämtlichen Aspekten enttäuschende Ergebnisse erzielt hat. Dies unterstreicht die anspruchsvolle Herausforderung bei der Beantwortung spezialisierter Fragen aus dem Bereich der GKV durch Large-Language-Modelle.

Aktualität der Rechtsgrundlagen und Benennung der Paragraphen

Ein wesentlicher Gesichtspunkt bei der Analyse und Bewertung der Antworten der einzelnen Large-Language-Modelle (LLMs) war die genaue Umsetzung und Benennung der rechtlichen Grundlagen. Hier zeigt sich bei allen getesteten LLMs ein unterschiedlich ausgeprägter Mangel in der korrekten Benennung von Paragraphen und zeitlich aktuell passenden Aussagen. Die generierten Antworten entsprachen häufig nicht den aktuellen rechtlichen Bestimmungen und beinhalteten veraltetet Summen und Grenzwerte. Dies stellt eine besondere Problematik dar, da die gestellten Fragen teilweise explizit auf den aktuellen Rechtsstand abzielten und ist daher besonders zu betrachten.

Ein Beispiel

Bei der Fragen nach der aktuellen Regelung zur Anspruchszeit in der gesetzlichen studentischen Pflichtversicherung (KVdS) wurden Antworten zur studentischen Krankenversicherung (KvdS) geliefert, die auf veralteten Informationen basierten.

Frage: Wie sind die Regelung zur Anspruchszeit auf eine studentischen Pflichtversicherung (KVdS) seit 2023 in der GKV?

Antwort: Seit 2023 beträgt die maximale Anspruchszeit auf studentische Pflichtversicherung, kurz KVdS, in der gesetzlichen Krankenversicherung, also GKV, 14 Semester oder bis zu einem Alter von 30 Jahren.

Korrekt ist jedoch, dass die Eingrenzung auf das 14. Fachsemester seit dem 01.01.2020 aus dem § 5 Abs. 1 Nr. 9 SGB V gestrichen wurde.

Warum agieren LLMs so ?

Um das volle Potenzial dieser Modelle auszuschöpfen, ist es von entscheidender Bedeutung, die Grenzen dieser Systeme zu erkennen und sie maßgeschneidert auf spezifische Anforderungen anzupassen. Trotz ihrer beeindruckenden Fähigkeiten sind LLMs nicht immer sofort einsatzbereit, und eine maßgeschneiderte Anpassung an spezifische Aufgaben und Domänen ist oft notwendig, um wirklich passende Ergebnisse zu erzielen. Für weitere Informationen zu dieser Thematik verweisen wir auf unsere aktuelle Artikelserie zum optimalen und spezifischen Einsatz von Large-Language-Modellen (LLMs).

Fazit

Die Ergebnisse unserer Untersuchung zeigen, dass LLMs wie ChatGPT4 durchaus in der Lage sind, einfache und grundlegende Fragen im Bereich der gesetzlichen Krankenversicherung korrekt zu beantworten. Nutzern sollte jedoch bewusst sein, dass die ausgegebenen Informationen, gerade wenn es um rechtliche Inhalte geht, mitunter nicht dem aktuellen Rechtsstand entsprechen.

Die Analyse der Ergebnisse zeigt darüber hinaus auf, dass die Qualität der generierten Antworten abnimmt, je komplexer und mehrschichtiger die fachlich geprägte Frage gestellt wird. Eine Anpassung der LLMs auf die spezifischen Anforderungen der jeweiligen Branchen ist daher grds. notwendig.

Auf Grundlage unseres entwickelten Tools sind detaillierte Analysen in allen Fragenkategorien möglich sowie auf Wunsch individuell anpassbar. Welche Unterkategorien sind in der Betrachtung weiter für Sie interessant? Häusliche Krankenpflege oder Fahrtkosten ?

Haben Sie Fragen und Anregungen zu unserem Tool oder wollen sich die ersten Auswertungen gerne näher erläutern lassen, dann melden sie sich gerne bei uns.

Kontakt: Kerstin Baasch

Kontakt: Dr. Kai-Uwe Morgenstern